📣 Associazione onData - Newsletter #30

Un workshop sui dati FAIR, "maneggiare" 23 GB di file CSV senza affanno, il primo compleanno del Data Book Club, quattro magnifici strumenti per raccontare storie con i dati

Ciao,

grazie per essere qui a leggere questa newsletter, per avere invitato altre/i a iscriversi, per darci spesso spunti per i contenuti che pubblichiamo.

🙏Se vuoi sostenerci, puoi farlo in questi modi.

👉 Se ci leggi da e-mail, fai click qui per leggerla per intero

👩🏫 Un workshop per scoprire come si rendono “belli” i dati

FAIR, è un acronimo inglese che sta per Findable, Accessible, Interoperable, and Reusable: trovabili, accessibili, interoperabili e riutilizzabili.

Sono carattistiche che rendono i dati “belli”, e a cui è dedicata una sezione dei “I dati che Vorrei”, a cui ti rimandiamo per un primo approfondimento.

È un concetto che ha radici profonde nel mondo scientifico, per rendere i risultati della ricerca non solo accessibili ma anche comprensibili, verificabili, replicabili e condivisibili. Dà valore a tutti i dati, anche ai dati aperti ed è infatti una delle raccomandazioni (la “3”) delle Linee Guida Open Data nazionali a cura dell’Agenzia per l'Italia Digitale (AgID).

Ma FAIR non è equivalente a Open: sebbene l'apertura dei dati sia un obiettivo desiderabile, i principi FAIR si concentrano sulla gestione e sull'uso etico ed efficiente dei dati, indipendentemente dalla loro disponibilità pubblica.

E questo importante concetto è uno dei tanti sottolineati nel workshop di Paola Masuzzo: “Dealing with FAIR data”.

È diviso in tre parti: prima un’ampia introduzione ai concetti di base, poi una che riguarda i principi FAIR in azione con esempi pratici per ciascuna delle quattro lettere e infine una serie di esercizi.

Per sviluppare quest’ultimi sono stati messi a disposizione dei file: avrai la possibilità di capire cosa sono i “tidy data” e di crearli (usando OpenRefine), e scoprirai come pubblicarli e descriverli, in modo che siano “senza attrito”, secondo le specifiche “Frictionless Data”.

Circa 120 slide, con un gran cura nei testi, nelle immagini, nel layout e nella sequenza. Una piccola/grande perla didattica, consigliata a chiunque crea, pubblica e usa dati.

🛰️ Gli Hub del progetto Copernicus

Uno dei limiti di Copernicus - il programma spaziale dell'Unione Europea dedicato all'osservazione della Terra - è sempre stato la difficoltà di capire quali vantaggi potessero offrire la moltitudine di dati e servizi disponibili, quasi sempre in modo gratuito, ai non addetti ai lavori geospaziali.

Per superare questo ed altre limitazioni sono nati gli Hub Tematici di Copernicus (Copernicus Thematc Hubs, CTHs), che mirano a raggruppare sotto un unico punto di accesso, a livello del programma Copernicus, l'insieme di dati, prodotti e informazioni generati da diversi servizi o componenti di Copernicus (incluse le componenti spaziali e in-situ) per specifiche aree tematiche o geografiche.

Per esempio il Coastal Hub di Copernicus mette a disposizione una selezione di dati di osservazione della Terra gratuiti e con licenze aperte che coprono le zone costiere europee, compresi prodotti e informazioni su aria, mare e terra che descrivono l'ambiente costiero e il complesso continuum terra-mare attraverso un'ampia serie di variabili. Nel Coastal Hub quindi troviamo dati costieri dai servizi Copernicus e dai satelliti Sentinel a sostegno dell'attuazione delle politiche ambientali, del Green Deal europeo e delle applicazioni di tipo accademico o industriale.

Lo scopo di questi Hub Tematici è soprattutto riconducibile a specifiche esigenze di politica a livello dell'Unione Europea: gli Hub devono infatti consentire al programma europeo di affrontare una serie di aspetti politici difficili da gestire attraverso un singolo servizio di Copernicus, come ad esempio questioni legate alla coerenza delle politiche o all'integrazione di elementi strategici in diverse politiche, coprendo regioni geografiche di interesse per l'Unione Europea.

Un’attività trasversale, quindi, che vuole semplificare il percorso dell'utente e facilitare l'accesso a informazioni chiave su aree di interesse selezionate per vari stakeholder, decisori politici e utenti. Queste aree comprendono tematiche identificate nel Regolamento Spaziale dell'UE e nel Green Deal, come biodiversità, salute, zone costiere, Artico, energia, Obiettivi di Sviluppo Sostenibile, patrimonio culturale, Accordo di Parigi, conformità ambientale, gestione dell'acqua, lotta agli eventi estremi e supporto allo sviluppo internazionale.

Gli Hub tematici di Copernicus in sostanza puntano a semplificare l'accesso ai prodotti esistenti di Copernicus per un dominio specifico, ed al tempo stesso migliorare il coordinamento tra progetti correlati, agevolare studi su temi specifici, fornire conoscenze e esperienze sui dati/prodotti, e mostrare integrazioni di dati attraverso casi d'uso e storie di successo.

Questi gli Hub:

sull’Artico, https://www.arctic.hub.copernicus.eu/

sulle zone costiere, https://www.coastal.hub.copernicus.eu/

sull’energia, https://energy.hub.copernicus.eu/

sulla salute, https://health.hub.copernicus.eu/

🧮 Esplorare 23 GB file CSV, come se fosse un “Excel” da 1000 righe (l’esempio dei dati di OpenCUP)

Due tra i siti che pubblicano da anni dati di grande interesse sono stati da poco aggiornati.

Uno è OpenCUP, che mette a disposizione i dati, in formato aperto, sulle decisioni di investimento pubblico finanziate con fondi pubblici nazionali, comunitari o regionali o con risorse private registrate con il Codice Unico di Progetto. La novità più importante di questo aggiornamento, è legata alla natura degli interventi in elenco: a “Lavori Pubblici” e “Incentivi alle imprese e Contributi per calamità naturali”, si aggiungono “acquisti di beni, servizi, corsi di formazione, strumenti finanziari, progetti di ricerca e contributi a entità diverse dalle unità produttive per una Pubblica Amministrazione più trasparente e vicina al cittadino” (qui la notizia di lancio).

➡️ In numeri si passa da circa 6,5 a 9,5 milioni di progetti.

Nella sezione OpenData, il nuovo file “Complessivo”: è un file CSV compresso da circa 2.9 Gigabyte, che diventano 23 GB se decompresso.

È probabilmente il file CSV più grande (o uno dei più grandi), pubblicato in una sezione open data di un sito di una Pubblica Amministrazione italiana. Non è gestibile con un comune foglio di calcolo (né con tanti altri strumenti), è troppo grande e inutilizzabile dalla gran parte degli utenti. È quasi inevitabile.

Utilizzando però delle modalità e degli strumenti “giusti”, si può esplorare, filtrare, e analizzare, con grande leggerezza e rapidità, come se fosse un “Excel” da 1000 righe.

E su questo il nostro Andrea Borruso ha scritto un tutorial dedicato, con un contributo di Matteo Fortini. Nel testo sono illustrati alcuni strumenti classici per leggere in modo molto semplice file di testo, che dovrebbero nella cassetta degli attrezzi di tutte le persone che “fanno cose” con i dati (non soltanto i “tecnici”). Ed è anche indicato come creare la versione in formato parquet, in modo da potere usare una query SQL per avere dei dati di sintesi in tempi rapidissimi su una tabella di circa 17.000.000 di righe e 90 colonne.

L’altro sito è quello di OpenCoesione, l'iniziativa di open government sulle politiche volte a garantire il rafforzamento della coesione economica, sociale e territoriale con l’obiettivo di ridurre le disparità di sviluppo fra le regioni. Nel portale sono pubblicati i dati aperti su queste politiche ed è stata aggiornata proprio la sezione open data del portale, in cui adesso è possibile consultare i dati, filtrarli e scaricarli per categoria degli interventi, ciclo di programmazione, programma di riferimento, tema e Regione. È annunciato anche il futuro utilizzo di nuovi formati di pubblicazione.

😲 Spoiler: nella prossima newsletter (salvo imprevisti), una sorpresa anche su OpenCoesione.

🔥 Il numero #2 di Liberiamoli tutti!

“Liberiamoli tutti!” è un'iniziativa della campagna #DatiBeneComune per individuare, ottenere, riformattare, pulire, documentare, pubblicare e diffondere dati di interesse pubblico.

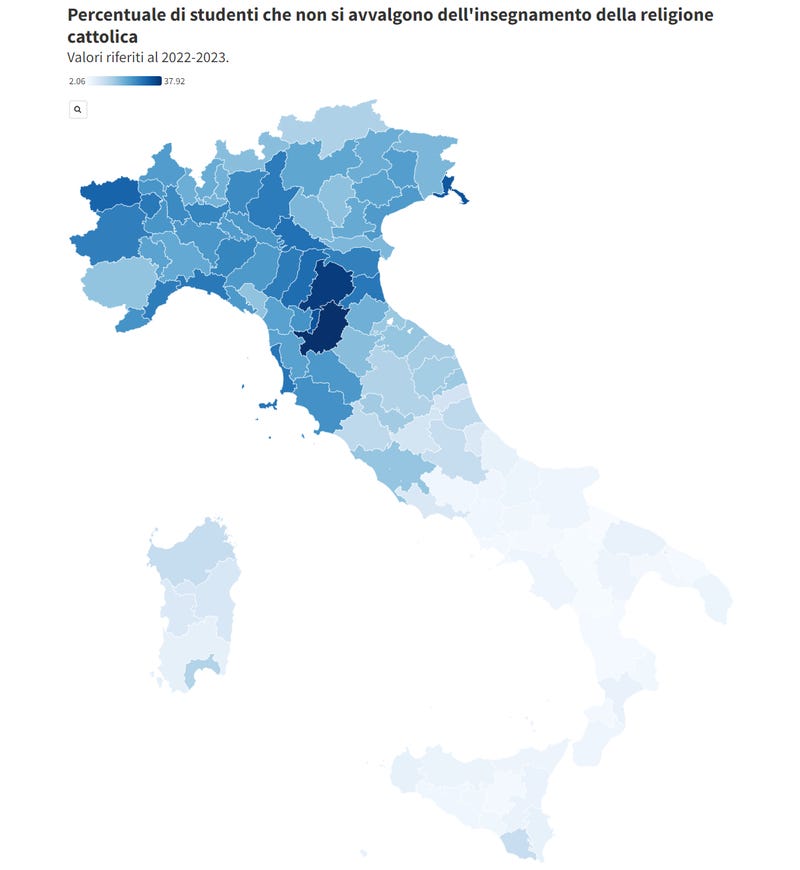

Ne numero #2 sono stati pubblicati i dati su sugli studenti che hanno scelto di non avvalersi dell’insegnamento della religione cattolica (IRC).

Nel 2022 la campagna #DatiBeneComune aveva già collaborato con l'Unione degli Atei e degli Agnostici Razionalisti (UAAR) per la pubblicazione di questi dati, ed è importante come l’UAAR si spenda perché venga data continuità a questa azione informativa.

Il Ministero dell'Istruzione e del Merito (MIM), pubblica diversi dati aperti. Ma ancora una volta è stata necessaria una richiesta FOIA dell’UAAR per fare in modo di acquisire dati e informazioni e renderli pubblici.

Le Pubbliche Amministrazioni dovrebbero pubblicare i loro dati come dati aperti (la norma di riferimento), e il MIM dovrebbe quindi rendere disponibili e aggiornare ogni anno anche i dati IRC nella sua piattaforma dati, senza che sia necessaria alcuna richiesta.

Infine sottolineiamo come non siano stati ottenuti tutti i dati richiesti e che sarebbe essenziale avere anche le informazioni su quali alternative all'ora di religione offra la singola scuola.

📺 Un anno di Data Book Club

Il Data Book Club è un gruppo di lettura diffuso (online) per leggere insieme libri dedicati ai dati e alla tecnologia, che ha festeggiato da poco il suo primo anno di vita.

Nasce grazie all’incontro di due “nerd” dei libri sui dati - Donata Columbro e Elena Canovi e ha il suo quartier generale su Telegram.

Mira a esplorare opere che trattano il tema dei dati con un approccio divulgativo e intersezionale, ponendo domande critiche sul modo convenzionale di discutere dati in contesti aziendali.

Non si limita a manuali tecnici, ma seleziona libri che stimolano riflessioni e dubbi.

Un aspetto distintivo del club è l'impegno a esaminare come i dati influenzano la società a diversi livelli, incluso l'impatto sulle questioni di genere, privacy, etica e governance. Questo approccio permette ai membri di sviluppare una comprensione più profonda e critica dell'uso e dell'abuso dei dati nel mondo contemporaneo.

Donata e Elena hanno festeggiato questo primo anniversario registrando un dialogo con un video “riassuntone” dei titoli scelti durante il 2023 e letti dalla community del DataBookClub:

Data Feminism, di Catherine D’Ignazio e Lauren F. Klein (MIT Press, 2020)

Macchine ingannevoli, di Simone Natale (Einaudi, 2022)

Discriminating Data, di Wendy Hui Kyong Chun (MIT Press, 2021)

Factfulness, di Hans Rosling (Rizzoli, 2018)

Big data e algoritmi, di Teresa Numerico (Carocci Editore, 2021)

La matematica è politica (Einaudi, 2020) + La tecnologia è religione (Einaudi, 2022) di Chiara Valerio

Gender Tech, di Laura Tripaldi (Laterza, 2023)

🤫 Sta arrivando anche nei portali italiani il formato parquet …??

Come ha scritto Éric Mauvière a dicembre del 2022 “Parquet dovrebbe sostituire il formato CSV”. Offre vantaggi significativi rispetto al CSV in termini di dimensioni del file, velocità di lettura e gestione dei tipi complessi dei dati.

Il CSV (come accennato sopra per i dati OpenCUP) è un formato file, che per file molto grandi, costituisce una grande barriera all’uso. Se è usato per stimolare e abilitare l’utilizzo da parte degli utenti, dovrebbe essere sempre accompagnato da uno schema dati leggibile meccanicamente che ne consenta la trasformazione in formati adatti alla gestione di grosse banche dati (sarebbe già una gran cosa, di grande usabilità per tutti, uno schema SQL).

E in tanti contesti, specie appunto per file di dimensioni importanti, il formato parquet sta diventando il formato di pubblicazione di dati aperti.

Anche in Italia si vedono i primi segnali: il portale Open Data del Comune di Bologna rende disponibili tutti i dati anche in formato parquet. Ce lo ha segnalato Francesco Paolicelli (grazie), mostrandoci il contenuto del catalogo/indice delle risorse del portale.

È ancora un’evidenza nascosta dietro le quinte, ma qui ad esempio è disponibile un file relativo a dei dati elettorali.

Se non sai come aprire un file parquet, puoi usare il comodo TAD, un visualizzatore gratuito e open source, per aprire file CSV, Parquet e database SQLite e DuckDb (sotto un esempio del file di sopra).

Se vuoi fare un query SQL live, puntando direttamente all’URL del file - perché è come avere delle API - puoi usare la shell web di DuckDB: ecco un esempio per avere un “summary” con le caratteristiche di questo file.

🔧 Se vuoi raccontare, rendicontare, mostrare, “cose”, pubblicare, a partire dai dati, hai degli strumenti magnifici

È un momento di maturità importante per gli strumenti per analizzare, condividere, riprodurre, storie da raccontare con i dati. Sono molto belli, ben documentati, in pieno e costante sviluppo e spesso con delle belle comunità alle spalle.

Qui te ne segnaliamo quattro. Ognuno meriterebbe un numero intero di newsletter, ma qui vogliamo essere sicuri che non te ne sfugga nessuno.

1️⃣ Il primo è Quarto - “Un sistema di pubblicazione scientifica e tecnica open-source” - in cui scrivi le tue storie in Markdown o partendo da un Jupyter notebook, per creare contenuti dinamici con Python, R, Julia, e Observable. È basato su Pandoc.

Potrai creare articoli scientifici, siti web e blog, libri in ePub, docx e PDF, presentazioni, con indici, citazioni, riferimenti incrociati, callout, dashboard e altro ancora.

È installabile su qualsiasi sistema operativo, e ha una comoda estensione per Visual Studio Code, per scrivere i propri progetti.

Visti i linguaggi che supporta, non ci sono limiti alle possibili fonti dati.

Ha una documentazione incredibile e una comunità molto attiva e reattiva. Il web è pieno di video con presentazioni e tutorial a tema: per chi inizia consigliamo questo.

2️⃣ Il secondo è Evidence - “un framework leggero per la creazione di applicazioni data based” - per la creazione tramite SQL di “storie”, report, dashboard, un'alternativa basata sul codice agli strumenti visuali di business intelligence in drag-and-drop.

Il modo più semplice per usarlo (e anche installarlo) è l’estensione Visual Studio Code dedicata.

Anche qui la modalità di scrittura principale è il testo in Markdown, mentre SQL è la modalità principale per “lavorare” i dati che si vogliono raccontare.

E ancora una volta, ha una documentazione molto ricca e leggibile.

Ha una ricca lista di tipologia di fonti dati e di componenti per creare grafici e altri elementi visuali.

3️⃣ Il terzo è marimo, un notebook Python con celle “reactive”, che consente di lavorare rapidamente con dati e modelli, di produrre notebook come pipeline o applicazioni web interattive.

Il formato dei file è un normale file Python e questi file possono essere eseguiti come "applicazioni", oltre a essere modificati nel blocco note. L'interfaccia è molto ben costruita, soprattutto per un progetto così giovane.

La novità forse più interessante è proprio quella delle celle “reactive”: se si modifica il valore o il codice di una cella (o si modifica il valore di un widget di input), tutte le altre celle che dipendono da quel valore si aggiornano automaticamente. E - come in Observable - non importa quale sia l’ordine delle celle.

Ha anche lui un’estensione Visual Studio Code, e una buona documentazione.

4️⃣ Il quarto è Observable Framework, che nasce perché (è il suo claim) “Le miglior dashboard sono costruite con il codice”.

Per creare applicazioni, dashboard e report di dati, veloci e belli, dalla riga di comando. Scrivendo in Markdown, JavaScript, SQL, Python, R... e qualsiasi altro linguaggio. Gratuito e open-source.

Il framework include un server per visualizzare in anteprima lo sviluppo fatto sul proprio PC e un'interfaccia a riga di comando per l'automazione di build e deploy.

Ci piace moltissimo l’idea dei loader dei dati, ovvero dei componenti che si possono scrivere in ogni linguaggio, per rendere disponibili i dati da usare negli output visuali da creare.

In output un sito statico. È tutto costituito da file, si può usare l'editor e il sistema di controllo di versione preferiti, condividere il codice con altre applicazioni e ospitare i progetti ovunque.

Include temi, griglie visuali e librerie per creare visualizzazioni leggibili da qualsiasi dispositivo, tra cui Observable Plot, D3, Vega-Lite, Graphviz, Mermaid, Leaflet, KaTeX (e per lavorare con i dati, Arquero, DuckDB e SQLite).

Bellissima la documentazione, ed è molto bella la procedura di “Get started” che ti porta a creare, visualizzare e modificare il primo esempio di output.

Tanti punti in comune tra (quasi) tutti questi straordinari strumenti: l’utilizzo del Markdown, la documentazione di qualità, il sottolineare quanto sia essenziale il “bel vedere” e la struttura per raccontare bene storie.

E come sottolineato nel workshop di Paola di inizio newsletter, l’importanza di poter mostrare, condividere e testare il processo di analisi fatto, per produrre la storia, la dashboard, il report, ecc..

📊 Il Bilancio di Stato 2024

Per il sesto anno i Copernicani presentano la visualizzazione percettiva del Bilancio di Stato 2024: navigazione e ricerca semantica negli oltre 1.200 miliardi di spesa pubblica con grafica interattiva, basati sugli open data del Ministero dell'Economia e delle Finanze.

Strumenti/risorse

📄Il profilo DCAT-AP per i dataset di alto valore.

🤣 “Gli amici non lasciano fare brutti grafici ai loro amici”, un saggio sulle buone e cattive pratiche di visualizzazione dei dati.

🔧 “Voici”, per convertire un notebook Jupyter in una dashboard interattiva (è un po’ il quinto della lista di sopra).

👩🏫 “Che differenza c'è tra il formato dati Wide e Long?” In questo video Alli Torban ce lo spiega in maniera semplice.

🧮 “Human Climate Horizons” (HCH), una piattaforma di dati e insights che fornisce informazioni localizzate sugli impatti futuri del cambiamento climatico su diverse dimensioni dello sviluppo umano e della sicurezza umana.

🗓️ Il “Data Research Camp”, un meeting di 4 giorni del Dipartimento di Statistica, Informatica, Applicazioni dell'Università di Firenze che si terrà a Firenze, dal 15 al 18 luglio 2024.

📊 Il report sulla qualità della vita nelle città europee, con mappe interattive, dati, questionari usati e PDF.

📚 Analisi dei dati del censimento degli Stati Uniti: metodi, mappe e modelli in R.

🎓 “2024 Cohort”, una borsa di studio estiva rivolta a studenti universitari o laureati in corso o neolaureati.

📊 “History of Data Visualization”, delle belle slide a tema, a cura di Michael Friendly

📺 “Presentazione Indice di Percezione della Corruzione”, a cura di Transparency International Italia.

🔧 “Shiny Express”, per rendere significativamente più facile iniziare a lavorare con Shiny.

📊 Datawrapper, il popolare tool web di data visualization, ha aggiunto il supporto agli small multiple line charts.

🧮 Sulla Piattaforma Nazionale Adattamento, sono disponibili i dati utilizzati per la definizione del “Piano Nazionale di Adattamento ai Cambiamenti Climatici”.

📄 AGID ha pubblicato il nuovo piano triennale per l'informatica nella PA 2024-2026, una sezione è dedicata alle azioni in tema di Open Data e Data Governance.

🧮 Tutte le organizzazioni francesi coinvolte nella distribuzione di elettricità e gas, uno sportello unico per i dati correlati.

📺 I webinar dell’European Master in Official Statistics - EMOS.

🔍 Un'inchiesta di Bloomberg svela come le compagnie energetiche abbiano tratto vantaggio dal lockdown durante l'emergenza COVID19.

📊 “Disuguaglianze nella mortalità per causa in Italia secondo caratteristiche demografiche, sociali e territoriali - Anno 2020”, a cura di Istat.

📖 “Code for Germany”, cura un gran bello spazio informativo. Questo post è un ottimo esempio.

Che numero ricco, finalmente ho preso il tempo per godermelo <3

Come sempre … strepitoso post 😀